Návody

Prihlásenie na klaster je možné len s použitím SSH kľúča. Pokiaľ ešte nemáte vygenerovaný SSH kľúč môžete si jeden vygenerovať podľa návodu.

Generovanie SSH kľúča

Totožnosť používateľov klastra sa pri ich prístupe overuje pomocou SSH kľúčov. Každý používatel si musí vygenerovať dvojicu kľúčov (súkromný a verejný). Verejný kľúč pošle administrátorovi klastra a súkromný kľúč si nechá len pre seba.

Generovanie v prostredí MS Windows

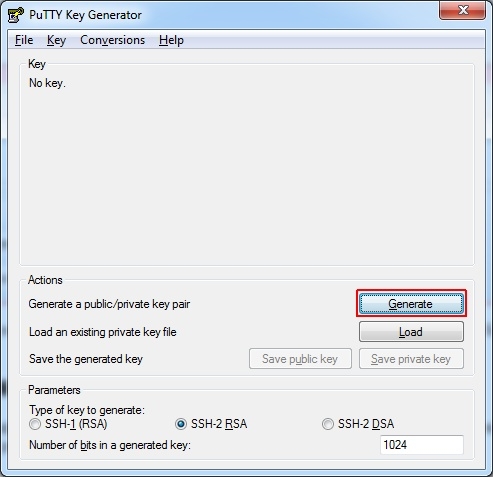

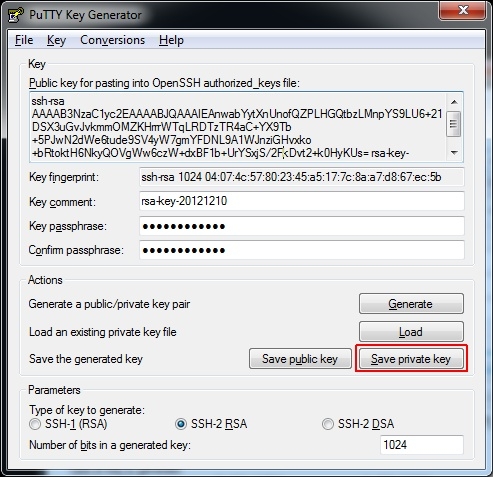

Pokiaľ používate operačný systém MS Windows, odporúčame na generovanie kľúčov použiť aplikáciu PuTTYgen. Stiahnuť si ju môžete zo stránky http://www.chiark.greenend.org.uk/~sgtatham/putty/download.html. Aplikáciu nie je nutné inštalovať. Môžete ju spustiť priamo z umiestnenia kde ste ju uložili pri sťahovaní (puttygen.exe).

1. Ťuknite na tlačidlo Generate:

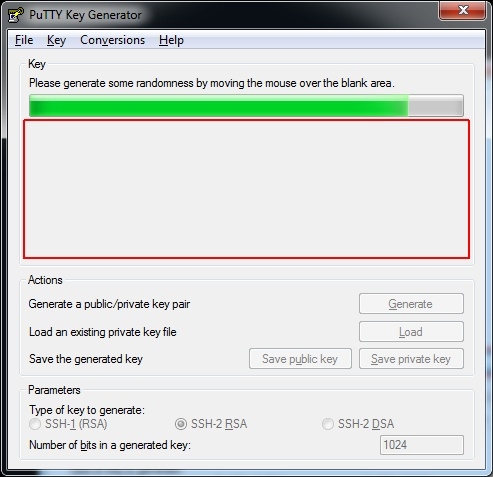

2. Náhodne pohybujte kurzorom myši vo vyznačenom obdĺžniku až kým nebude k dispozícii dostatok náhodných dát pre generovanie kľúča:

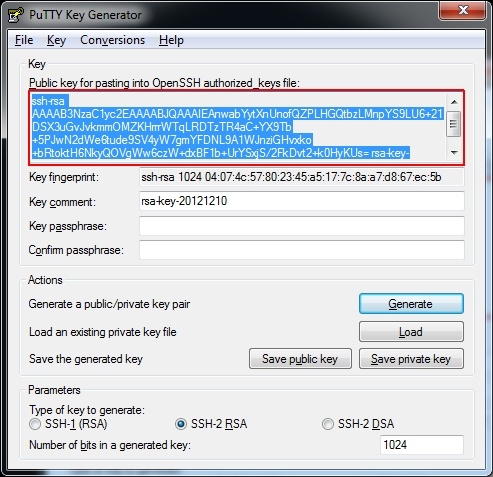

3. Po vygenrovaní je verejný kľúč zobrazený vo vyznačenej oblasti. Odtiaľ ho skopírujte do prázdneho textového súboru (celý) a tento súbor pošlite adminitrátorovi klastra. Kľúč má tvar:

ssh-rsa AAAAB3NzaC1yc2EAAAABJQAAAIB3TrNOqgpod3AyvWVr+z9SrcInjj9lwElO3SBFMON1jQslL1KcAJbiY3+AaEXYHtM8jaU+uXBImSvNEQ67BV6uL3W/fObJRdz+b/yPRCPbHljNM7YGvis/tZuvlntYgQr8jhBSH3RAOgHKeApFY3TxZxUNwaLBzlf8g/72qduspw== rsa-key-20121210

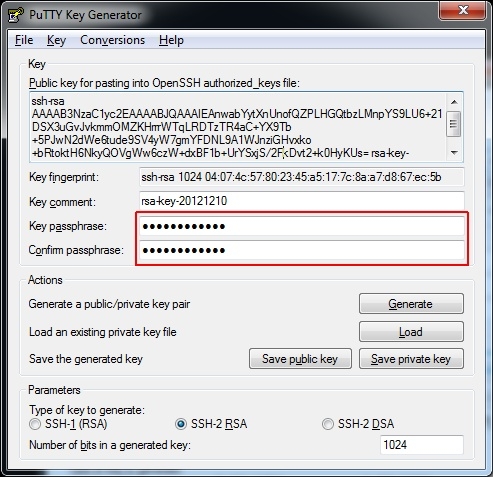

4. Zadajte heslo pre privátny kľúč. Toto heslo budete musieť zadať vždy keď budete chcieť kľúč použiť.

5. Ťuknite na tlačidlo Save private key a súkromný kľúč uložte na bezpečné miesto.

Podobne môžete uložiť aj verejný kľúč stlačením tlačidla Save public key, ale takto uložený kľúč nebude priamo použiteľný pre prístup na klaster a administrátorovi ho v tomto formáte NEPOSIELAJTE!

Prihlásenie sa na klaster

Aby mohol záujemca využívať výpočtové prostriedky niektorého z klastrov spravovanych HPCC musí sa obrátiť na administrátora so žiadosťou o vytvornie prístupu. Súčaťou žiadosti musí byť verejný SSH kľúč. Ak takýto kľúč nemáte môžete si ho vygenerovať podľa návodu.

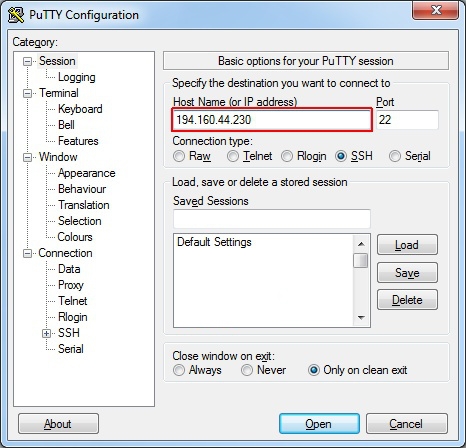

Prihlásenie sa na klaster z prostredia MS Windows

Pre prihlásenie sa na klaster z OS MS Windows budete potrebovať softvér, ktorý umožní vzdialené pripojenie cez SSH. Odporúčame použiť program PuTTY. Môžete si ho stiahnuť zo stránky http://www.chiark.greenend.org.uk/~sgtatham/putty/. Program nevyžaduje inštaláciu a môžete ho spustiť priamo z umiestnenia kde ste ho uložili pri sťahovaní.

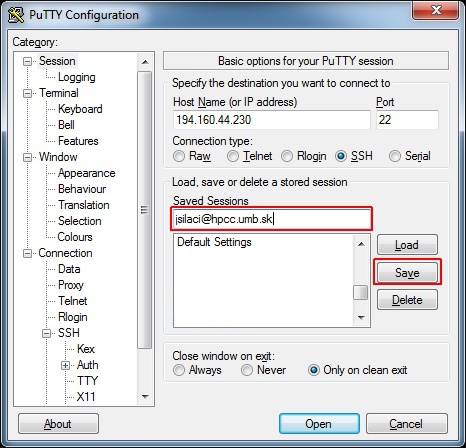

1. Vyplňte IP adresu servera (194.160.44.230), na ktorý sa budete prihlasovať:

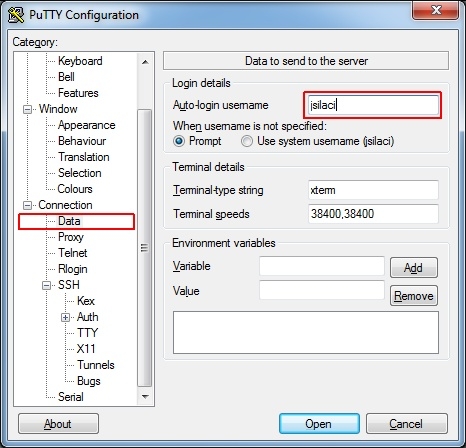

2. Ťuknite na položku Connection->Data a vyplňte používateľské meno (Auto-login username), ktoré vám bolo pridelené administrátorom:

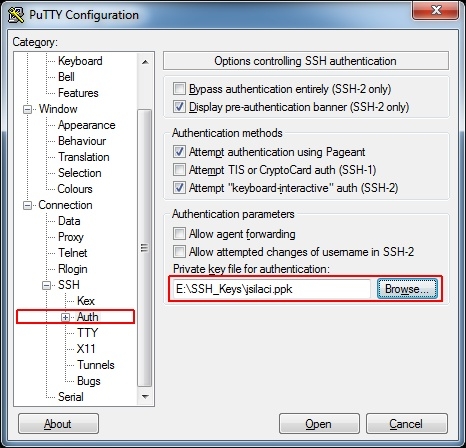

3. Ťuknite na položku Connection->SSH->Auth a vyberte umiestnenie vášho privátneho kľúča, ktorý ste vygenerovali podla návodu:

4. Ťuknite na položku Session, vyplňte názov pre uloženie nastavení, ktoré ste práve urobili.

5. Ťuknite na tlačidlo Open a budete prihlásený ku klastru.

Spúšťanie úloh

O plánovanie spúšťania úloh sa stará systém Torque. Aby ste mohli na klastri spustiť úlohu musíte použiť "spúštací skript", ktorý definuje parametre úlohy a jej požiadavky na výpočtové prostriedky. Pri každej úlohe je potrebné zadefinovať parameter "PBS -A", ktorý nám pomôže identifikovať ku ktorému projektu úloha patrí a lepšie tak monitorovať využívanie klastra.

Skript do systému odošlete príkazom:

qsub my_job.sh

Informácie o svojich úlohách v systéme získate po zadaní príkazu:

qstat

Spustenú úlohu zrušíte príkazom:

qdel job_id

Job_id získate z výstupu príkazu qstat (prvý stĺpec).

Príklad spúštacieho skriptu (obsah súboru my_job.sh):

#!/bin/sh

### Set the job name

#PBS -N testovaci-program### Set the project code (no spaces)

#PBS -A TESTOVACI-PROJEKT

### Declare myprogram non-rerunable

#PBS -r n### Optionally specify destinations for your program's output.

### Specify localhost and an NFS filesystem to prevent file copy errors.

### Without these lines or if the paths are invalid, PBS will redirect

### stdout and stderr to files in your home directory.

#PBS -e localhost:/home/jsilaci/test.err

#PBS -o localhost:/home/jsilaci/test.log### Optional similar syntax words might work for staging files.

### #PBS -W stagein=/scratch/file.in@localhost:/full/file.in

### #PBS -W stageout=/scratch/file.out@localhost:/full/file.out### Set the queue to "batch".

#PBS -q batch### Specify the number of cpus for your job. This example will run on 16 cpus

### using 8 nodes with 2 processes per node.

### You MUST specify some number of nodes or Torque will fail to load balance.

#PBS -l nodes=1### You should tell PBS how much memory you expect your job will use. mem=1g or mem=1024m

#PBS -l mem=256m### You can override the default 1 hour real-world time limit and 24-hour CPU-time.

### Shortening the default CPU-time may improve your chances of running as a back-fill job.

### Check out the current back-fill availability by running /usr/local/maui/bin/showbf on psi.

### or see the tail end of the status page: http://freak.millennium.berkeley.edu/psi/status.html

### -l walltime=HH:MM:SS and -l cput=HH:MM:SS

### Jobs on the public clusters are currently limited to 10 days walltime.

#PBS -l walltime=1:00:00

#PBS -l cput=24:00:00

### Switch to the working directory; by default Torque launches processes from your home directory.

### Jobs should only be run from /work; Torque returns results via NFS.

echo Working directory is $PBS_O_WORKDIR

cd $PBS_O_WORKDIR### Run some informational commands.

echo Running on host `hostname`

echo Time is `date`

echo Directory is `pwd`

echo This jobs runs on the following processors:

echo `cat $PBS_NODEFILE`### Define number of processors

NPROCS=`wc -l < $PBS_NODEFILE`

echo This job has allocated $NPROCS cpus### Use gexec to run a program on the assigned processors. $GEXEC_SVRS is automatically defined for you.

### gexec -n 0 myprogram### Alternatively, run a parallel MPI executable.

/usr/lib64/openmpi/bin/mpirun -v -machinefile $PBS_NODEFILE -np $NPROCS /home/jsilaci/mpitest/priklad